You are here

MongoDB от теории к настройке Replica Set + Arbiter

В этой статье разберем основные вопросы по MongoDB:

- Установка и настройка MongoDB

- Настройка конфигурационного файла MongoDB

- Создание Primary и Secondary в Replica Set

- Подключение в Replica Set регулятора Arbiter

- Эксперимент: удаляем Secondary и делаем из него Arbiter

- Проверка работы Replica Set

- Разбор ошибок и их решение

- Варианты создания Replica Set

В нашем случае, развернули Replica Set в локальной сети. За основу взяли дистрибутив Debian 9 и 10 (если настраиваете на CentOS, там примерно всё тоже самое). Материал в статье будет интересен тем, кто первый раз знакомится с MongoDB. Все будем делать поэтапно, с пояснением по каждому моменту.

1. Установка и настройка MongoDB на наши сервера:

Если вы не знаете как поставить MongoDB на ваш Linux, всегда можно обратиться к официальному сайту: docs.mongodb.com (раздел: Install MongoDB > Install MongoDB Community Edition > Install MongoDB Community Edition on Linux >).

Перед началом всех действий, не забываем делать update, далее добавляем репозито́рий: mongodb-org.list и debian-stretch.list:

Делаем update после правки репозитория и ставим libcurl3:

Устанавливаем саму MongoDB: Install MongoDB Server on Debian 10

Проверяем:

Данные пакеты входят в пакет выше по умолчанию:

- "mongodb-org hold"

- "mongodb-org-server hold"

- "mongodb-org-shell hold"

- "mongodb-org-mongos hold"

- "mongodb-org-tools hold"

Стартуем при запуске:

Проверяем статус установленной базы:

Повторяем те же действия для остальных. Мы использовали 3 сервера.

2. Настройка конфигурационного файла MongoDB /etc/mongod.conf. Содержимое нашего файла ниже:

Тут мы прописали "0.0.0.0", чтобы был полный охват. Обратим внимание на следующие строки:

Тут указываем имя replSet, у нас это "mongoset" (имя задаете сами для всего Replica Set):

Можно сказать, что основную работу мы сделали. Теперь немного о командах для MongoDB:

- sudo service mongod start

- sudo service mongod stop

- sudo service mongod restart

- systemctl - стандартные варианты

- mongo - вход в саму базу

3. Создание Primary и Secondary в Replica Set или Deploy a Replica Set:

* Внимание:

Первая проблема, с которой мы столкнулись, это несоответствие версии MongoDB. Так как мы использовали разные версии Linux, при работе с sources.list внесли разные версии «mongodb-org/4.2» и «mongodb-org/4.0», из-за чего они не работали в Replica Set. На это надо обратить внимание!

* Внимание: если возникла ошибка типа:

Process: 2928 ExecStart=/usr/bin/mongod —config /etc/mongod.conf (code=exited, status=1/FAILURE)

Необходимо проверить синтаксис /etc/mongod.conf в части IP и наличие не поврежденных (удаленных) каталогов:

/var/log/mongodb и /var/lib/mongodb/. Если их нет (в нашем случае, при замене версии MongoDB, удалили все каталоги, а новые не встали), то создать и прописать права от mongodb:

Определяем какой из наших серверов будет основным или правильнее сказать Primary, и заходим в MongoDB:

После входа в MongoDB, отразится приглашение для ввода запросов:

Проверяем статус rs.status(). Начальный статус должен быть 0 - startup. Означает что узел не является членом ни одной реплики.:

Производим "Инициализацию реплики" только для одного (он и будет Primary): Run rs.initiate() on just one and only one mongod instance for the replica set. Для этого используем шаблон с официального сайта:

На основе шаблона, вместо "abc'" пишем наш вариант "mongoset", указанный в файле /etc/mongod.conf. Далее прописываем IP (через данный шаблон можно добавить сразу несколько серверов), мы сделаем один. Остальные добавим позже:

Итогом станет такой вывод:

Проверяем конфигурацию:

Проверяем статус rs.status() и видим, что "mongoset:SECONDARY" сменилось на "mongoset:PRIMARY":

Самый важный элемент кода выше "stateStr" : "PRIMARY":

Ну вот, мы добавили первый сервер, который сразу стал "PRIMARY"! Продолжим...

3.1. Дальше нам надо добавить остальные сервера из нашей сети, по шаблону с официального сайта:

Добавляем второй сервер или "SECONDARY" из под "mongoset:PRIMARY":

Итогом станет, появление следующего фрагмента в команде mongoset:PRIMARY> rs.status()

Весь вывод не отражаю, суть понятна! После добавления третьего SECONDARY у нас будут примерно такие статусы при вводе запроса rs.status():

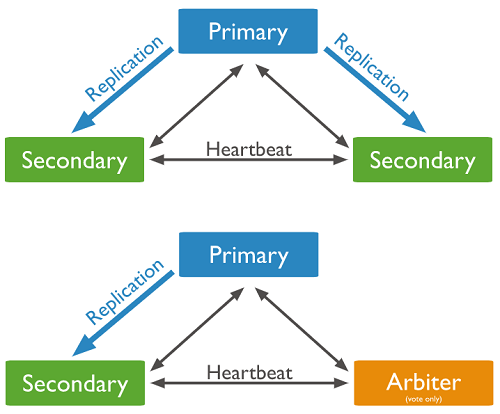

- Primary

- Secondary

- Secondary

3.2. Другой путь: при котором мы добавляем Primary и Secondary не по отдельности, а сразу все сервера, через шаблон выше:

* Внимание: может возникнуть ошибка, если на начальном этапе вы сразу добавили не один сервер, а несколько. Связанная Host Name. В нашем случае, оказалось, что при выводе команды rs.status() в поле отвечающем за информацию по IP подтянулось значение HostName. Вместо "192.168.0.5:27017", было "debian".

Как исправить? Из под строки ввода запросов MongoDB (проблемного сервера) набираем последовательно следующий список значений, со своим IP:

Если не примет последнюю команду, так как у вас скорее всего будет Secondary, пишем её так:

После чего, перепроверяем через rs.status(), может понадобиться перезагрузка MongoDB, чтобы встало верное значение. Этой же командой можно менять IP в случае переезда MongoDB Secondary с одного IP на другое.

Остальное повторно писать не буду, так же как и выше.

4. Подключение в Replica Set регулятора Arbiter

Если рассматривать "Secondary + Secondary + Primary", то такая система вполне себе рабочая, в случае отказа одного из серверов, оставшиеся два сами перевыберут нужного Primary. Если в этом будет необходимость. Но это не так круто, как использования для этих целей Arbiter. Теперь подробнее.

Обращаясь к официальному сайту, мы можем найти такой шаблон:

Но перед тем как добавлять Arbiter из под Primary, нужно еще пару шагов. Нужно создать директорию под нужды Arbiter:

Дальше ввести данные по шаблону:

И только после этого, добавить сам Arbiter (192.168.0.20):

На выводе запроса rs.status(), получим такой вывод (это часть вывода!):

В итоге у нас такая связка: "ARBITER + Secondary + Primary"

5. Эксперимент: удаляем Secondary и делаем из него Arbiter

Это скорее не раздел для действий, а эксперимент

Мы уже умеем добавлять Primary и Secondary к нему. Но, нам нужно реализовать воображаемую ситуацию: один Secondary сделать ARBITER. Для этого нам надо удалить Secondary, и добавить его уже как ARBITER.

Удаляем ранее добавленный Secondary (IP 192.168.0.5) из под Primary:

Проверяем что получилось, через rs.status(). Итогом станет, что Secondary пропадет из списка. Далее добавляем папки для ARBITER (см. выше) и сам ARBITER через команду на Primary:

Но запрос статуса, выведет вместо "stateStr" : "ARBITER", значение:

Танцы с бубном, привели к следующему решению (не призываю к действию, у вас может быть более логичное решение). Нужно почистить папку на сервере "192.168.0.5 Secondary":

Выйти из MongoDB, а на Primary ввести запрос, проверить статус:

Надо отметить, что мой PRIMARY временно стал SECONDARY, но после активации ARBITER, все встало на свои места. В данном эксперименте были пропущенные такие шаги как:

- отключение и включение SECONDARY: для удаления данных из папки

- Ввод команды rs.status() несколько раз

Так как если описывать каждый шаг, статья будет в разы больше! Но суть передал максимально точно.

6. Проверка работы Replica Set

Самое главное: проверить работу базы!

И так, Тестирование. Добавим базу на Primary и просмотрим на Secondary.

PRIMARY 192.168.0.9

SECONDARY 192.168.0.14

Проверяем на Secondary:

* тут надо дать пояснение: просто так в базу через Secondary "не зайти/не увидеть"! Так как доступ к базе только из под PRIMARY. Но есть лазейка, использовать rs.slaveOk(). Но на официальном сайте крайне не рекомендуют её применять, что мы и вам советуем. Но у нас база для тестов, была не была:

Всё работает.

7. Разбираем оставшиеся вопросы

Почему важно понимать сколько у вас SECONDARY+PRIMARY+ARBITER:

Важно! Если у вас в связке "1 PRIMARY и 2 SECONDARY", то при выходе из строя PRIMARY, пройдет голосование. Выбор будет между 2х SECONDARY, кто-то из них станет PRIMARY. В итоге останется один SECONDARY и один PRIMARY.

По умолчанию выбор будет случайный среди определенных кандидатов. Можно задавать кто кем будет, назначая вес приоритета выбора.

Суть голосования: в связке с 3 серверами, голосование проходит один раз, большинством голосов: 2/3 против 1/3. Т.е. Если умрут 2 сервера из трех, то последний SECONDARY не сможет назначить себя PRIMARY, так как его голос будет 1/3 от изначальных 3. Это важно понимать!

Другой вариант, у вас 1 PRIMARY, 1 ARBITER, 3 SECONDARY, т.е. всего 5! Если у вас упадет PRIMARY, то большинством 4/5 будет переизбран новый PRIMARY из 3-х оставшихся SECONDARY. Если умрет еще один, т.е. по факту у вас уже 2 умерло, и 3 живых. Голосование пройдет как 3/5. А если умирает уже 3 сервера из 5, то голосование не пройдет, так как голоса будут 2/5 против уже умерших 3/5.

Поэтому нужно понимать сколько вы закладываете серверов и какая отказоустойчивость будет. Надеюсь наш пример и небольшие эксперименты будут для вас полезны!

Ну и на последок, если решите удалить:

Источник: http://linuxsql.ru